Il tuo carrello è attualmente vuoto!

Gestione degli ambienti critici cloud: best practice operative

Secure Cloud di WIIT: performance, resilienza e fiducia

Con un incremento dei gravi attacchi informatici del 65% in Italia e costi di downtime che possono raggiungere 9.000 dollari al minuto, le imprese non possono più accontentarsi di piattaforme solo scalabili: cercano affidabilità, sicurezza by design e conformità costante. In questo contesto, il Secure Cloud di WIIT nasce per evitare compromessi: un set integrato di infrastrutture, processi, servizi e tecnologie che unisce alta disponibilità, localizzazione del dato e resilienza operativa. La promessa è concreta: spostare la complessità di sicurezza e compliance sul provider, permettendo all’azienda di concentrarsi su prodotti, clienti e innovazione, inclusi i nuovi casi d’uso basati su AI generativa.

Secondo il report “Cost of a Data Breach 2025” di IBM, il costo medio di una violazione dei dati in Italia è sceso a 3,31 milioni di euro, segnando un calo del 24% rispetto all’anno precedente. Questo dato, sebbene in miglioramento, evidenzia come l’impatto finanziario di un incidente di sicurezza rimanga una delle principali preoccupazioni per le aziende. I costi non includono solo le perdite dirette, ma anche i danni reputazionali, le sanzioni normative e le spese per il ripristino dei sistemi.[IBM]

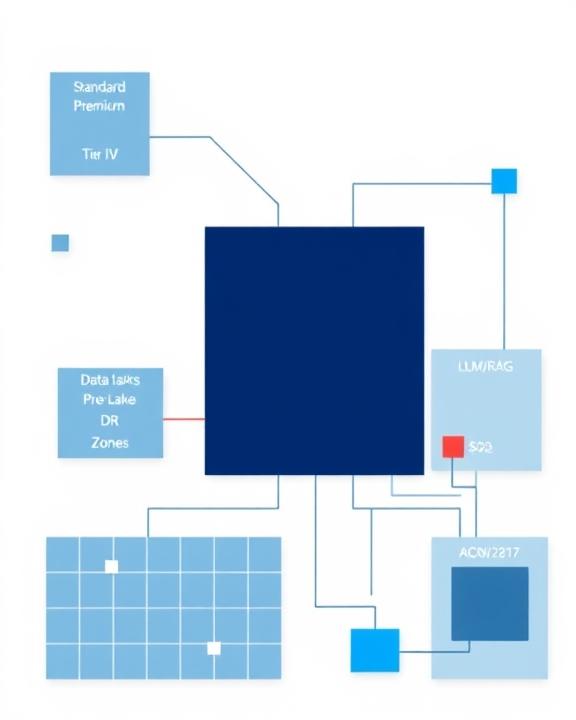

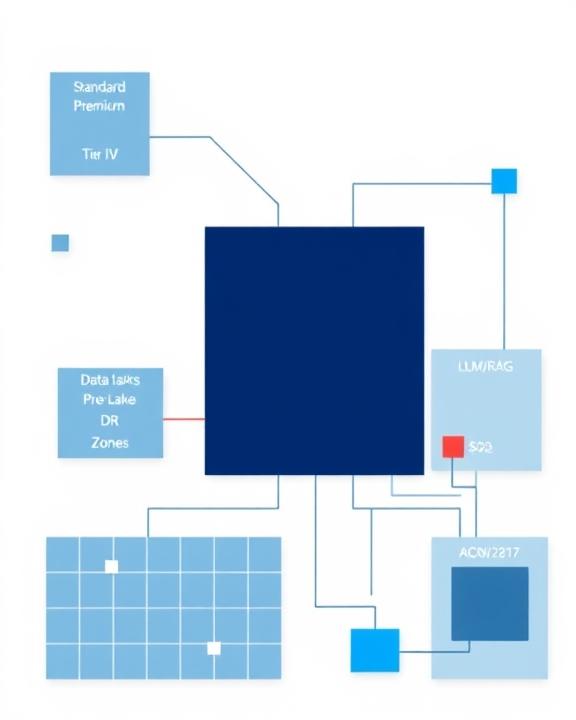

Il paradigma Secure Cloud non coincide con un singolo servizio: la sua forza è architetturale e organizzativa. La piattaforma si fonda su un network europeo di data center proprietari multi-Tier IV, raggruppati in Region (Germania, Italia, Svizzera), con Zone di servizio modulari che adattano i controlli a rischio e requisiti. La Zona Standard porta in dote security by design di alto livello (tra cui vulnerability management, segmentazione di rete e high availability nativa), riducendo la superficie d’attacco e garantendo scalabilità senza compromessi. La Zona Premium, attivabile dove sono presenti i data center certificati Tier IV o ad altissima resilienza, estende i controlli a tutti i macro-processi della cyber security, integra un SOC 24/7 e strumenti proattivi di threat detection & response, pensati per ambienti con workload critici e necessità di gestione SLA molto stringenti. La Zona DR mette a disposizione servizi di backup e disaster recovery configurabili secondo i RTO/RPO richiesti.

Due aspetti spiccano per chi deve governare la gestione ambienti critici cloud su orizzonti pluriennali. Primo: l’approccio cloud-native impiegato per evitare lock-in tecnologico, così che l’azienda mantenga libertà di scelta e una postura evolutiva coerente con standard e benchmark di settore. Secondo: la piattaforma è costruita per accelerare l’adozione dell’AI in modo sicuro, valorizzando GPU farm, data pipeline robuste e controlli di data governance che attenuano i rischi di shadow AI e di data leakage. In altre parole, Secure Cloud fornisce una foundation su cui poggiare processi mission critical e, allo stesso tempo, abilitare nuovi workload (LLM, applicazioni di visione artificiale, automazioni data-driven), senza sacrificare conformità e resilienza operativa.

La logica è la stessa che guida la selezione di un cloud provider “di fiducia”: prestazioni, resilienza, sicurezza e conformità normativa diventano criteri imprescindibili. WIIT propone una piattaforma pensata per costruire questo trust su basi verificabili: Zone predefinite, processi gestiti, monitoraggio continuo e data center multi-Region, che permettono di soddisfare requisiti di territorialità, business continuity e compliance di settori regolamentati. Questo impianto consente di unire velocità di esecuzione e riduzione del rischio operativo, qualità ricercata da CIO e CISO impegnati a bilanciare time-to-market e aderenza normativa.

Per approfondire l’impostazione architetturale e i vantaggi della piattaforma, sono disponibili ulteriori dettagli su Secure cloud, porta sicurezza e compliance ai massimi livelli. L’approccio by design di WIIT punta a industrializzare la sicurezza e a rendere ripetibili i processi di gestione degli ambienti critici, così da assicurare che resilienza, scalabilità e compliance siano parte integrante della piattaforma, non un’estensione estemporanea.

Data center e resilienza: classificazioni, costi e outsourcing

Il data center resta il cuore pulsante della trasformazione digitale: ospita le risorse di network, storage e computing su cui si reggono i processi aziendali e, per estensione, la business continuity. All’interno, network (prestazioni e sicurezza), storage (tutela e disponibilità dell’informazione) e compute (server fisici e virtuali) sono le colonne portanti, orchestrate da sistemi di alimentazione ridondanti, impianti di raffreddamento, sicurezza fisica multilivello, monitoring e meccanismi di backup & restore. Negli anni, la virtualizzazione di tutti i layer (rete, storage, calcolo) ha dato vita al modello di Software-Defined Data Center (SDDC), in cui le risorse si gestiscono via software con maggiore agilità, scalabilità e governance unificata.

Sul piano della resilienza, i benchmark internazionali aiutano a distinguere livelli di garanzia. Il sistema di rating più diffuso è quello di Uptime Institute, articolato in quattro Tier. Un Tier IV garantisce una disponibilità media annua del 99,995% grazie a ridondanze su tutte le componenti critiche e all’implementazione del concetto di fault tolerance. In parallelo, lo standard ANSI/TIA-942 adotta una scala a quattro livelli (“Rated”), con un diverso impianto certificativo: Uptime Institute esegue un test che verifica concretamente la resilienza dichiarata; TIA prevede la conformità a uno standard con audit e ispezioni da parte di enti terzi. Per workload critici, le imprese tendono a privilegiare ambienti attestati ai livelli più alti, che garantiscono high availability e fault tolerance per processi regolati e applicazioni di continuità.

| Classificazione Tier | Disponibilità Annua Garantita | Caratteristiche Principali | Downtime Massimo Annuo |

|---|---|---|---|

| Tier I | 99,671% | Singolo percorso per alimentazione e raffreddamento, senza componenti ridondanti. | 28,8 ore |

| Tier II | 99,741% | Singolo percorso per alimentazione e raffreddamento, con componenti ridondanti. | 22 ore |

| Tier III | 99,982% | Percorsi multipli per alimentazione e raffreddamento, manutenibile in contemporanea. | 1,6 ore |

| Tier IV | 99,995% | Completamente fault-tolerant con ridondanza su ogni componente. | 26,3 minuti |

La sicurezza non è soltanto logica. L’accesso fisico ai locali, la videosorveglianza, i sistemi antintrusione e di disaster prevention restano fondamentali. A questi si affianca la sicurezza logica: autenticazione, crittografia, segmentazione, monitoraggio e capacità di rispondere agli incidenti riducendo MTTR. Da qui discende la scelta, per molte imprese, di una strategia di outsourcing. La complessità tecnologica crescente, l’evoluzione delle minacce e la carenza di competenze specialistiche spingono ad affidarsi a operatori terzi con asset certificati e processi gestiti, in grado di offrire SLAs garantiti sulle mission-critical applications. Il modello non è “tutto o niente”: è possibile esternalizzare solo i core process o le funzioni che traggono maggior beneficio da data center Tier IV, mantenendo in house componenti selezionati.

WIIT investe in data center di proprietà con certificazioni d’eccellenza, anche per i contesti più regolamentati. La disponibilità di Premium Zone abilitate ai massimi livelli di resilienza è la base su cui costruire servizi di continuità del business e gestione ambienti critici cloud. Per approfondimenti sugli aspetti infrastrutturali e di classificazione, è utile la risorsa Data Center per aziende: cos’è, classificazioni e costi. Il percorso di modernizzazione di molti IT dipartimentali passa, oggi, attraverso modelli ibridi: mix virtuosi di ambienti in-house e cloud privati/pubblici, orchestrati per conciliare territorialità del dato, prestazioni applicative e compliance.

Da ultimo, la sostenibilità economica pesa sulla scelta. Un data center proprietario impone capex e opex importanti, aggiornamenti costanti e un investimento continuo in competenze. L’outsourcing verso un premium provider consente di “acquistare” resilienza, sicurezza e monitoraggio ambienti critici come servizi, con efficienza e tempi di adozione ridotti. È uno schema coerente con il bisogno diffuso di ridurre il rischio operativo e garantire risultati misurabili sul fronte di gestione SLA, uptime e disponibilità dei servizi digitali.

AI platform: ingestion, storage e analisi per ambienti data-driven

La gestione dei dati è diventata la linfa degli ambienti cloud moderni. Le aziende, chiamate a orchestrare flussi in crescita da fonti eterogenee, guardano alle AI platform come strumenti per automatizzare l’ingestion, ottimizzare lo storage e abilitare analisi avanzate. Una piattaforma AI fornisce infrastruttura, tool e algoritmi per sviluppare, addestrare e distribuire modelli a beneficio di data scientist, sviluppatori e analisti. Applicazioni trasversali – dalla previsione dei comportamenti dei clienti alla supply chain optimization – dimostrano come questi stack aiutino a sostenere processi automatizzati data-driven, estendendo la capacità decisionale con insight predittivi.

Nel dettaglio, la fase di ingestion si beneficia di automazioni capaci di raccogliere input da diverse origini, riconoscendo schemi e adattandosi all’evoluzione del dato. In storage, tecniche di data management come classificazione automatica e archiviazione intelligente migliorano efficienza e scalabilità. Sfruttando il cloud, la piattaforma alloca dinamicamente risorse in base a pattern d’uso e supporta analisi predittive per prefigurare esigenze di archiviazione ed evitare colli di bottiglia o perdite informative. Sul fronte analitico, la capacità di trattare grandi volumi (strutturati e non) con tecniche come NLP e computer vision permette di generare modelli sempre più accurati a supporto del business.

La preparazione dei dataset è cruciale. Con algoritmi “vuoti” – da addestrare su grandi quantità di dati non strutturati – funzionano bene i data lake, navigabili negli stadi di training e setting. Se invece si impiegano Large Language Model preaddestrati, in grado di comprendere il linguaggio naturale e rispondere coerentemente, lo standard architetturale più adatto per contestualizzare il modello è quello dei database RAG (Retrieval-Augmented Generation), che organizzano e servono knowledge specialistiche al modello per ottenere risposte accurate e aggiornate. In tutti i casi, la data quality è una priorità: rumore e spazzatura imputati al sistema si riflettono nei risultati, specie con modelli generativi. Per questo, stanno vivendo una nuova stagione i database vettoriali e le architetture di object storage, in particolare se collocate near data source, così da coniugare qualità e velocità di elaborazione.

L’intelligenza artificiale non è più una tecnologia futuristica, ma un motore di trasformazione presente in tutti i settori. Le piattaforme AI basate sul cloud forniscono l’agilità e la scalabilità necessarie per democratizzare l’accesso a queste tecnologie, permettendo anche alle PMI di competere su un piano di parità con le grandi corporation. La vera sfida non è tecnologica, ma culturale e organizzativa.

Accelerare questo percorso richiede spesso un cloud provider capace di pacchettizzare soluzioni end-to-end, con tecnologie già allocate (dallo storage alle GPU farm, fino a configurazioni edge per avvicinare archivi e sorgenti) e applicazioni pronte, installabili in data center proprietari o on-premise. È lo stesso approccio secure-by-design del Secure Cloud WIIT, che costruisce pipeline dati e operatori di analisi entro un perimetro controllato, combinando gestione ambienti critici cloud e monitoraggio ambienti critici. Un approfondimento operativo è disponibile su AI platform, come gestire ingestion, storage e analisi senza criticità, che illustra come dati, infrastruttura e algoritmi vadano concertati per liberare valore senza introdurre fragilità architetturali o di conformità.

Hybrid cloud: sicurezza, flessibilità e governance

Il cloud ibrido mette insieme tre componenti – cloud privato in-house, cloud privato ospitato presso provider specializzati e cloud pubblico – per massimizzare l’allocazione dei carichi nel miglior ambiente, contenere i costi e innalzare sicurezza e prestazioni. È una risposta concreta alle esigenze di controllare i dati sensibili e al tempo stesso beneficiare dell’agilità del pubblico, evitando sovradimensionamenti delle infrastrutture interne. In pratica, con il modello ibrido si può mantenere in private le architetture più critiche e utilizzare il public per picchi o servizi a minor rischio, in una governance estesa che gestisce l’ecosistema come un unicum e favorisce scalabilità rapida e ottimizzazione delle risorse.

Il mercato cloud ibrido in Italia: una crescita inarrestabile

Il mercato Public & Hybrid Cloud in Italia continua a mostrare una crescita robusta. Le stime per il 2024 indicano un valore complessivo di 4,8 miliardi di euro, con un incremento del 30% rispetto all’anno precedente. Questa tendenza è destinata a consolidarsi anche nel 2025, spinta dalla necessità delle aziende di modernizzare le infrastrutture IT, ottimizzare i costi e accelerare l’innovazione, sfruttando al contempo la flessibilità e la scalabilità offerte dai modelli ibridi. [Osservatori.net]

Tre benefici emergono con decisione. Primo: sicurezza. Il cloud ibrido somma le misure protettive dei diversi ambienti, distribuisce e replica i dati riducendo il rischio di perdita e consente l’adozione di soluzioni avanzate (segmentazione, vulnerability management, cifratura, zero-trust a livello architetturale). Secondo: flessibilità. Si bilanciano dinamicamente risorse tra pubblico e privato in base a esigenze, costi e punti di forza, innescando scalabilità efficiente anche near real time. Terzo: governance. Il controllo sui dati sensibili resta nell’infrastruttura privata, garantendo conformità normativa elevata, mentre si sfrutta l’agilità del pubblico per innovare e ridurre il time-to-market.

I numeri confermano la direzione: 262 miliardi di dollari è la stima del mercato globale del cloud ibrido per il 2027; il mercato italiano di public & hybrid cloud è cresciuto del +22% nel 2022. Un modello integrato di gestione, sotteso da processi e piattaforme consolidate, abilita un runtime continuo (uptime 24/7), condizione imprescindibile per ambienti mission-critical. Per percorsi di adozione e playbook operativi è possibile consultare le risorse di approfondimento di WIIT su Business continuity e cloud ibrido.

Per molte organizzazioni, la gestione ambienti critici cloud passa dal definire dove collocare workload e dati a seconda del profilo di rischio, dei requisiti di compliance e delle prestazioni richieste. È qui che un partner come WIIT, con Secure Cloud e data center multi-Tier IV, semplifica il governo di ambienti ibridi e multicloud, integra controlli di sicurezza e mantiene gestione SLA coerente su tutte le Region. L’obiettivo è singolare e misurabile: tutelare i core process e, insieme, aprire spazio all’innovazione sicura.

NIS2 in Italia: scadenze, obblighi e impatti operativi

La direttiva NIS2, recepita in Italia con il D.lgs. 138/2024, ridefinisce la platea di soggetti obbligati e gli adempimenti per la resilienza digitale, introducendo un percorso di attuazione graduale con scadenze a partire da aprile 2026. Vengono individuate due categorie: Soggetti Essenziali e Soggetti Importanti. L’estensione del perimetro rispetto a NIS1 include settori come ricerca, poste, servizi ICT, acque reflue, servizi digitali, manifatturiero (chimica, alimentare) e spazio. I criteri dimensionali (grandi, medie, piccole e micro imprese) si basano su dipendenti e fatturato; le micro e piccole sono coinvolte solo se ricadono nei settori critici previsti.

Sanzioni NIS2: cosa rischiano le aziende

Il mancato adeguamento alla direttiva NIS2 comporta sanzioni severe. Per i Soggetti Essenziali, le multe possono raggiungere i 10 milioni di euro o il 2% del fatturato globale annuo, a seconda di quale importo sia maggiore. Per i Soggetti Importanti, le sanzioni arrivano fino a 7 milioni di euro o l’1,4% del fatturato globale annuo. Oltre alle sanzioni pecuniarie, sono previste misure correttive e, nei casi più gravi, la sospensione delle autorizzazioni e la pubblicazione delle violazioni, con un conseguente danno reputazionale.[Vega Formazione, Agenda Digitale]

Il calendario operativo presentato evidenzia un insieme di scadenze ricorrenti e milestone di sistema. Dal 1° dicembre di ogni anno le aziende devono registrarsi sul portale ACN tramite un punto di contatto; tra 1° gennaio e 28 febbraio è prevista anche la registrazione o l’aggiornamento sulla piattaforma. Dal 1° gennaio 2026 scatta l’obbligo di notifica degli incidenti informatici. Entro il 31 marzo le aziende registrano o aggiornano l’iscrizione; entro il 1° ottobre 2026 l’Autorità pubblica l’elenco dei soggetti essenziali e importanti. Entro il 15 aprile, tramite piattaforma, le aziende accedono ai dati relativi alla propria collocazione; entro 15 aprile e 31 marzo devono aggiornare le informazioni su IP pubblici, nomi di dominio, stati membri di distribuzione e responsabili della sicurezza. Il monitoraggio ambienti critici e la trasparenza anagrafica diventano così esigenze concrete e calendarizzate.

L’art. 21 di NIS2 delinea le aree su cui le entità devono adottare misure tecniche e organizzative adeguate: analisi dei rischi, autenticazione a più fattori, sicurezza dei sistemi, strategie cyber, gestione degli incidenti, controllo degli accessi, tutela della supply chain, formazione, business continuity, sistemi crittografici. Il legislatore spinge verso una postura proattiva, fatta di scadenze chiare e collaborazione con ACN. Per le aziende con posture già mature, è ragionevole attendere le determinazioni ACN per fine-tuning; per realtà meno protette, è opportuno agire tempestivamente, coinvolgendo partner qualificati. Il costo medio di adeguamento è stimato attorno a 280.000 euro per azienda, cifra che va contestualizzata rispetto al costo di un data breach: le fonti citate ricordano effetti economici significativi e tempi medi lunghi per identificare e contenere violazioni, con sanzioni in crescita.

- Responsabilità diretta del management: Gli organi di gestione sono direttamente responsabili dell’approvazione e della supervisione delle misure di cybersecurity.

- Formazione obbligatoria: Il management deve seguire corsi di formazione specifici per comprendere e valutare i rischi informatici.

- Gestione del rischio della supply chain: Le aziende devono valutare e gestire i rischi di sicurezza derivanti dai loro fornitori diretti e partner.

- Obblighi di notifica stringenti: Gli incidenti significativi devono essere notificati all’autorità competente (CSIRT) entro 24 ore dalla scoperta, con un report dettagliato entro 72 ore.

La governance NIS2 richiede anche consulenza legale per determinare la collocazione nel perimetro e gestire l’evidenza documentale. Per il cliente WIIT, la disponibilità di data center Tier IV, Zone Premium con SOC 24/7 e un’architettura secure-by-design facilita l’adozione di misure e controlli coerenti con l’art. 21, oltre a supportare la gestione SLA richiesta da workload mission-critical. WIIT, inoltre, offre Security Assessment mirati all’adeguamento, contribuendo a definire piani di miglioramento prioritari e documentabili in sede ispettiva. Un approfondimento tematico è disponibile via Direttiva NIS2 e data center. Questa roadmap normativa è, a tutti gli effetti, un catalizzatore per maturare processi, tecnologie e competenze orientate alla cyber resilience.

Rischi e frodi nel finance: lezioni per tutti i settori

Il settore finance rimane tradizionalmente uno dei più bersagliati dal cyber crime. Nel 2020, la finanza e le assicurazioni hanno rappresentato il 23% degli attacchi globali, risultando la top attacked industry dell’anno. L’impatto economico di un singolo evento può essere elevatissimo: il costo medio nel finance è stato stimato in 5,72 milioni di dollari per violazione, secondo i dati riportati, secondo solo ai 9,23 milioni dell’healthcare. Questi numeri non sono rilevanti solo per le banche: sono un indicatore di priorità per qualsiasi organizzazione che tratti dati sensibili e workload essenziali. La lezione è chiara: resilienza, monitoraggio e consapevolezza devono muoversi di concerto.

Difendersi dalle frodi informatiche bancarie richiede un approccio sistemico. Infrastrutture solide, data protection coerente al modello (on-prem, private o public cloud) e monitoraggio continuo delle reti e degli asset – attività tipiche dei SOC – sono il primo livello. È altrettanto cruciale la difesa proattiva, comprensiva di aggiornamenti, hardening e test periodici. Nell’era cloud, poi, il paradigma di sicurezza cambia radicalmente: le difese non possono essere solamente perimetrali; occorre costruire controlli trasversali (identità, privilegi, segmentazione, detection, risposta) aderenti alle architetture ibride e multicloud.

Resta, tuttavia, l’anello umano. Dipendenti con accesso a sistemi interni diventano bersaglio privilegiato di phishing, social engineering e campagne mirate. La security awareness efficace – personalizzata, coinvolgente, con simulazioni realistiche e gamification – trasforma il fattore umano da vulnerabilità a linea di difesa attiva. È un investimento con ritorno tangibile: riduce incidenti, migliora il reporting degli eventi e allinea comportamenti quotidiani alle policy. Nel contesto NIS2, questa dimensione diventa parte integrante degli obblighi del framework (formazione e consapevolezza), a testimonianza che la resilienza è anche una questione culturale.

Per i clienti WIIT, la combinazione di Secure Cloud (Zone Standard e Premium), SOC 24/7 e programmi di awareness si traduce in una riduzione concreta del rischio di frode e interruzione operativa. Nelle realtà regolamentate – come banche e assicurazioni – la disponibilità di data center Tier IV e di una gestione SLA orientata alla business continuity supporta politiche di runtime continuo, ripristino rapido e compliance ai requisiti di settore. Chi opera in altri comparti (manifatturiero, fashion, pharma, food & beverage) può adottare queste stesse best practice come baseline, perché la gestione ambienti critici cloud con controlli strutturati e monitoraggio ambienti critici non è un’esclusiva del finance: è una condizione essenziale per un digitale affidabile in ogni settore.

Una lettura utile per inquadrare le principali minacce e la necessità di un approccio olistico alla difesa è disponibile su Frodi informatiche bancarie: quanto costano e come proteggersi. Il messaggio di fondo – attualissimo anche per NIS2 – è che preparazione tecnica e comportamenti consapevoli devono procedere insieme, con partner qualificati e processi verificabili.

Lascia un commento