Il tuo carrello è attualmente vuoto!

Come orchestrare cloud ibridi senza perdere controllo

Multicloud e cloud ibrido: contesto, definizioni operative e traiettorie del mercato

Nel lessico dell’IT contemporaneo, multicloud e cloud ibrido non sono sinonimi, ma rispondono a esigenze complementari. Le fonti specialistiche concordano su una definizione funzionale: per multicloud si intende l’utilizzo, da parte di un’organizzazione, di servizi di cloud computing erogati da almeno due provider per eseguire applicazioni e carichi di lavoro, combinando cloud pubblici e/o privati; il cloud ibrido combina invece ambienti privati (on-premises o private cloud) e un ambiente pubblico, orchestrando carichi di lavoro comuni su più domini tecnologici. Nel multicloud, i servizi di provider diversi possono restare separati sul piano operativo oppure essere integrati affinché applicazioni in cloud differenti comunichino e condividano dati, riducendo duplicazioni e ottimizzando l’uso di risorse e servizi.

- Multicloud: Strategia che prevede l’utilizzo di servizi cloud di più provider (pubblici o privati) per diversi carichi di lavoro, che possono rimanere operativamente separati.

- Cloud Ibrido: Architettura che integra un ambiente privato (on-premise o private cloud) con almeno un cloud pubblico, consentendo la portabilità di dati e applicazioni tra di essi.

- Vendor Lock-in: Situazione in cui un cliente è dipendente da un singolo fornitore per prodotti e servizi, non potendo passare a un altro senza costi o complicazioni significative.

- TCO (Total Cost of Ownership): Costo totale di esercizio; una metrica finanziaria per stimare tutti i costi, diretti e indiretti, associati a un asset o a un sistema per l’intero suo ciclo di vita.

- SLA (Service Level Agreement): Accordo sul livello del servizio; un contratto che definisce il livello di servizio che un fornitore si impegna a erogare a un cliente, specificando metriche come uptime, performance e responsabilità.

- IaaS (Infrastructure as a Service): Modello di servizio cloud che fornisce risorse di calcolo virtualizzate (infrastruttura) via Internet.

- PaaS (Platform as a Service): Modello che offre una piattaforma hardware e software su cui gli sviluppatori possono creare, distribuire e gestire applicazioni senza la complessità di costruire e mantenere l’infrastruttura sottostante.

- SaaS (Software as a Service): Modello di distribuzione del software in cui un provider ospita le applicazioni e le rende disponibili ai clienti su Internet tramite un abbonamento.

- Kubernetes: Piattaforma open-source per l’orchestrazione di container, che automatizza il deployment, la scalabilità e la gestione di applicazioni containerizzate.

- Direttiva NIS2: Normativa europea (Network and Information Security, seconda versione) che mira a elevare il livello di cybersicurezza comune in tutta l’UE per i settori critici e importanti.

- ACN (Agenzia per la Cybersicurezza Nazionale): L’autorità nazionale italiana per la cybersicurezza, responsabile della protezione degli interessi nazionali nel cyberspazio.

- OT (Operational Technology): Tecnologia operativa; hardware e software dedicati al monitoraggio e al controllo di processi e dispositivi fisici in ambienti industriali (es. sistemi SCADA).

Il quadro competitivo ha accelerato queste scelte. La letteratura di settore rileva che le strategie multicloud offrono libertà di selezione della funzionalità migliore per ogni workload, mitigano i vincoli da fornitore (vendor lock-in) e incrementano affidabilità e ridondanza, riducendo il rischio di single point of failure. La spinta verso scalabilità, resilienza e innovazione si è consolidata negli ultimi anni, anche per effetto delle pressioni macroeconomiche e della trasformazione digitale diffusa. Sul fronte ibrido, l’esperienza di impresa mostra come la Private Cloud – sia in-house sia in modalità ospitata/gestita – continui a essere la sede elettiva dei workload mission-critical, grazie a controllo, personalizzazione e capacità di audit tipiche dell’on-premises, oggi integrate con gli automatismi e la scalabilità propri del cloud pubblico in architetture unificate di gestione.

Il mercato cloud italiano in forte accelerazione

Le più recenti analisi di mercato confermano un’espansione senza precedenti del cloud in Italia, spinta in modo significativo dall’adozione dell’intelligenza artificiale. Secondo i dati dell’Osservatorio Cloud Transformation del Politecnico di Milano, il mercato ha raggiunto un valore di 6,8 miliardi di euro nel 2024, segnando una crescita del +24% rispetto all’anno precedente.[Osservatori.net] Questo incremento è il più alto registrato negli ultimi sei anni.

| Segmento di Mercato (2024) | Valore (Miliardi di €) | Crescita vs 2023 | Driver Principale |

|---|---|---|---|

| Public & Hybrid Cloud | 4,8 | +30% | Servizi infrastrutturali (IaaS) e piattaforme per AI (PaaS) |

| Infrastructure as a Service (IaaS) | 2,1 | +42% | Sperimentazione e sviluppo di applicazioni innovative |

| Platform as a Service (PaaS) | 0,845 | +23% | Utilizzo di API per Large Language Models (LLM) |

| Software as a Service (SaaS) | 1,8 | +21% | Integrazione di funzionalità AI in piattaforme esistenti |

Le previsioni a medio termine rafforzano questa tendenza: si stima che il mercato del cloud computing in Italia possa raggiungere i 12,45 miliardi di dollari nel 2025 e superare i 31,75 miliardi di dollari entro il 2030, con un tasso di crescita annuale composto (CAGR) del 20,6%.[Mordor Intelligence]

Diverse evidenze quantitative aiutano a contestualizzare il fenomeno. Un’analisi di mercato riportata in letteratura segnala che nel comparto finanziario l’85% dei carichi di lavoro critici non risulta ancora in Public Cloud, elemento che conferma la centralità di modelli ibridi e privati in settori regolamentati. Parallelamente, il dibattito sulla cloud repatriation – la ricollocazione di applicazioni e dataset dal Public Cloud verso infrastrutture private – evidenzia dinamiche reali: un sondaggio di fine 2021 (451 Research, “Voice of the Enterprise: Datacenters”, via block&files) riportava che il 48% dei CIO aveva già spostato applicazioni o grandi workload dal rispettivo hyperscaler a un’altra infrastruttura, e che nell’86% dei casi la destinazione era un data center di proprietà. Le cause principali includevano l’evitare il lock-in, insoddisfazioni prestazionali e l’ottimizzazione dei costi totali di esercizio (TCO).

La nuvola si conferma un pilastro imprescindibile per il percorso di digitalizzazione delle imprese del nostro Paese e consentirà di rispondere all’enorme domanda di servizi connessi all’intelligenza artificiale. Le organizzazioni devono quindi prepararsi ad accogliere l’impatto di questa trasformazione, cavalcando l’onda senza esserne travolte.

La scelta dell’architettura – single provider, multicloud, ibrida – non è solo tecnica: ha impatti su compliance, presidio del rischio, modelli di costo e velocità di rilascio. Le fonti delineano una prassi emergente: utilizzare il pubblico per la scalabilità pressoché illimitata (ad esempio in analisi dati e intelligenza artificiale), mantenendo in Private Cloud i processi più sensibili. In questa cornice, WIIT Group sottolinea come la Private Cloud, specie in modalità managed/hosted, consenta tenuta prestazionale, supervisione e single-tenancy con Service Level Agreement stringenti, integrandosi con risorse pubbliche in una gestione unificata che previene dispersioni e inefficienze.

Le pratiche applicative moderne – container, microservizi, Kubernetes – sono citate come abilitanti di portabilità e coerenza di gestione in scenari multi-provider. È su queste basi che le aziende costruiscono una strategia che “mappa” i requisiti di ogni carico (prestazioni, latenza, residenza del dato, sicurezza) al servizio più idoneo, pianificando in anticipo interoperabilità, governance e controlli.

Vantaggi e limiti: tra performance, lock-in, TCO e interoperabilità

Le fonti tecniche concordano su un nucleo di benefici del multicloud: flessibilità di scelta per “il meglio di ogni cloud”, assenza di vincoli a un unico fornitore, ottimizzazione dei costi selezionando per workload la combinazione più favorevole prezzo/prestazioni, maggiore affidabilità grazie a ridondanze e geografie alternative, e conformità facilitata, potendo distribuire dati e applicazioni in aree con requisiti locali stringenti. La Private Cloud aggiunge single-tenancy, controllo granulare e trasparenza dei costi, elementi che risultano decisivi in settori ad alta regolazione, come sanità e finanza.

In parallelo, emergono quattro aree di attenzione ricorrenti:

- Data security e protezione dei dati. La sicurezza in ambienti cloud richiede configurazioni corrette delle componenti di rete, aggiornamenti continui, e strumenti di Identity & Access Management avanzati. Le fonti evidenziano come API non certificate, accordi di servizio incompleti o scarsa trasparenza possano generare esposizioni impreviste. I rimedi includono architetture security-by-design, firewall, antivirus e scelte di connettività adeguate alla disponibilità richiesta.

- Complessità in ambienti multi-provider. Le impostazioni multi-cloud sono complesse da orchestrare: misconfigurations, patching non allineato, approcci deboli alla data governance e scarsa granularità del dato ostacolano il controllo dei workflow e l’applicazione uniforme delle policy. Per mitigare, le fonti indicano soluzioni di gestione ad hoc e, prima dell’ingaggio con un provider, la definizione di standard di interoperabilità e portabilità che riducano colli di bottiglia nella trasformazione degli application stack, nella cifratura durante le migrazioni e nella messa in esercizio di rete e servizi.

- Prestazioni e disponibilità. La qualità del servizio percepita dal business dipende dall’infrastruttura del fornitore e dalla bandwidth disponibile. La connettività incide in particolare dove vi siano grandi trasferimenti tra client e server; reti non affidabili aumentano il rischio di interruzioni e integrità dati compromessa. Il suggerimento operativo è investire in as-a-service affidabili, con monitoraggio real-time e architetture ridondanti per sostenere alta disponibilità.

- Migrazione: tempo, costi e competenze. Spostare dati e applicazioni richiede skill adeguati, una roadmap realista e una pianificazione dei costi. Le fonti notano la crescita di tooling e workflow cloud-ready, ma raccomandano il supporto di un provider con approccio consulenziale lungo l’intero ciclo – dal disegno alla gestione – per ridurre rischi e time-to-value.

Il tema dei costi complessivi (TCO) resta centrale sin dagli esordi del cloud. L’esperienza riportata suggerisce che, a parità di condizioni e su orizzonti temporali prolungati, talune configurazioni Private Cloud possano risultare più favorevoli rispetto alla spesa variabile del pubblico, soprattutto ove la scala fissa e i requisiti di controllo prediligano modelli previsionali e trasparenti. In aggiunta, outsourcing e Hosted/Virtual Private Cloud aiutano a comprimere la gestione infrastrutturale, beneficiando di economie di esperienza e know-how specialistico.

Nel confronto con il multicloud, i report dei fornitori evidenziano ulteriori vantaggi potenziali: migliore latenza globale grazie alla capillarità dei data center, disaster recovery cross-cloud, compliance per aree geografiche diverse, e accesso tempestivo a tecnologie innovative (ad esempio servizi di AI, data analytics, service mesh). Tuttavia, le sfide citate – gestione più complessa, sicurezza e conformità coerenti tra cloud, interoperabilità, controllo dei costi – richiedono un design rigoroso. Qui il ruolo del partner diventa determinante: WIIT Group sottolinea che la qualità degli SLA, l’ampiezza dell’offerta e la disponibilità di una infrastruttura proprietaria certificata – incluse Premium Zone e data center Tier IV – sono fattori che impattano direttamente business continuity e performance.

Governance e sicurezza: modelli di controllo, requisiti normativi e paradigma “Secure Cloud”

La governance è indicata come primo obiettivo negli ecosistemi multicloud e ibridi. L’esperienza riportata dal mercato italiano (fonte: osservatorio citato in letteratura tramite ZeroUno) racconta che già nel 2021 il 34% delle grandi imprese utilizzava servizi Public Cloud di più fornitori; dopo decisioni tattiche adottate durante la pandemia, l’urgenza si è spostata sulla gestione centralizzata degli asset: sicurezza, costi e app management. Le piattaforme di orchestrazione consentono di automatizzare configurazioni e policy, abbattere gli sprechi attraverso uno scaling dinamico rispetto ai carichi effettivi e pagare solo i servizi necessari, con identity & access management, log analytics e controlli di rete coordinati su tutti i domini. In sintesi, una console unica per governare ambienti eterogenei.

Anche la prospettiva cyber spinge a questa unificazione. Un’analisi indipendente (Coleman Parkes, citata nel materiale fornito) segnala che il 69% dei CISO ritiene che la digital evolution renda più difficile la gestione delle vulnerabilità; contestualmente, la cloud adoption impone di potenziare i team con specialisti non sempre disponibili. Il risultato tipico sono punti ciechi negli ambienti cloud, consumi di risorse dovuti a monitoraggi manuali inefficaci e un aumento del rischio di attacchi informatici, con impatti su costi, business e reputazione. La via d’uscita proposta è una sicurezza “embedded” e proattiva, sostenuta da soluzioni basate su AI e machine learning, con accesso a tecnologie best-of-breed e pratiche di resilienza dinamica su processi e ambienti.

Nel perimetro industriale, l’urgenza è confermata da un rilievo Bloor Research che il materiale riporta: il 74% delle imprese non dispone di un processo attivo di OT Risk Assessment e l’81% non ha un piano di risposta a incidenti OT; la convergenza IT/OT rende i sistemi manifatturieri esposti anche a vettori d’attacco apparentemente semplici (ad esempio e-mail). Strumenti, processi e servizi gestiti – tra cui Security Operations Center e modelli di security-as-a-service – diventano quindi determinanti per garantire business resilience e continuità operativa.

Sul fronte regolatorio, la Direttiva NIS2 recepita in Italia con il D.lgs. 138/2024 amplia il perimetro rispetto alla NIS1 includendo settori come ricerca, poste e corrieri, servizi ICT, acque reflue, servizi digitali, spazio e specifiche aree del manifatturiero (chimica, alimentare, gestione rifiuti). I soggetti “Essenziali” e “Importanti” in settori critici e ad alta criticità sono tenuti a implementare misure tecniche e organizzative adeguate (art. 21): analisi dei rischi, autenticazione a più fattori, sicurezza di sistemi e asset, gestione degli incidenti, controllo degli accessi, tutela della supply chain, formazione, business continuity e crittografia.

NIS2: Dalla Conformità alla Leva Strategica

Adeguarsi alla Direttiva NIS 2 e al Regolamento DORA non è solo un obbligo normativo, ma un’opportunità strategica. La pianificazione di roadmap e budget adeguati è cruciale per trasformare la compliance in un vantaggio competitivo. Secondo gli esperti, un percorso strutturato deve iniziare con un risk assessment e una gap analysis per mappare le vulnerabilità e definire le priorità.[Aruba Magazine] Successivamente, è possibile distribuire gli investimenti nel tempo, concentrandosi non solo sulla tecnologia ma anche sulla formazione interna e sulla governance, che rappresentano asset fondamentali per incrementare la resilienza e ridurre i costi a lungo termine legati a incidenti e sanzioni.

Il calendario attuativo prevede la registrazione sul portale ACN a partire dal 1° dicembre di ogni anno tramite un “punto di contatto”, adempimenti ricorrenti dal 2025 e ulteriori obblighi (come la notifica degli incidenti) dal 2026. Il documento segnala una stima media dei costi di adeguamento intorno a 280.000 euro per azienda, a fronte di un costo medio di data breach nel 2024 pari a 4,71 milioni di euro.

NIS2 e la responsabilità della supply chain

La Direttiva NIS 2, recepita in Italia, pone una forte enfasi sulla sicurezza della catena di fornitura (supply chain). I fornitori di servizi ICT, specialmente quelli di medie e grandi dimensioni, non sono più solo partner tecnologici ma diventano un anello cruciale della catena di resilienza dei loro clienti. La normativa impone loro obblighi specifici e un approccio proattivo alla sicurezza, rendendo i Consigli di Amministrazione direttamente responsabili della governance cyber.[Cybersecurity360] Questo significa che la scelta di un provider non può più basarsi solo su criteri tecnici ed economici, ma deve includere una valutazione approfondita della sua postura di sicurezza e della sua conformità normativa, che diventano garanzie contrattuali.

I Pilastri Tecnici e Metodologici della NIS 2

Per guidare le organizzazioni, l’Agenzia dell’Unione Europea per la Cybersicurezza (ENISA) ha delineato 13 pilastri implementativi che costituiscono un framework completo per la conformità. Questi requisiti non sono una semplice checklist, ma un modello integrato per la resilienza a livello aziendale.[ICT Security Magazine]

| Framework di Implementazione NIS2 secondo ENISA | ||

|---|---|---|

| 1. Politica sulla sicurezza dei sistemi | 2. Politica di gestione dei rischi (approccio “all-hazards”) | 3. Gestione degli incidenti (dalla policy al post-incidente) |

| 4. Continuità operativa e gestione delle crisi (BCP/DR) | 5. Sicurezza della catena di fornitura (supply chain) | 6. Sicurezza in acquisizione, sviluppo e manutenzione (SSDLC) |

| 7. Valutazione dell’efficacia delle misure | 8. Igiene informatica e formazione sulla sicurezza | 9. Crittografia e gestione delle chiavi |

| 10. Sicurezza delle risorse umane e accessi | 11. Policy di controllo degli accessi (fisici e logici) | 12. Gestione e classificazione degli asset |

| 13. Sicurezza ambientale e fisica | ||

L’adozione di questo framework richiede un impegno strategico da parte del top management e un investimento coordinato in tecnologia, processi e competenze.

Per rispondere a queste sfide, WIIT Group propone il paradigma Secure Cloud, costruito per ospitare workload critici con livelli elevati di resilienza, sicurezza e scalabilità già nei servizi di base. La piattaforma si fonda su un network europeo di più di 20 data center proprietari raggruppati in 7 Region (4 in Germania, 1 in Svizzera, 2 in Italia), garantendo compliance e territorialità del dato, e su “Zone” attivabili per Region: Standard (security by design con vulnerability management, segmentazione, alta disponibilità), Premium (nei siti a massima resilienza, estende la sicurezza a tutti i macro-processi e integra un SOC 24/7) e DR (servizi di backup e disaster recovery flessibili). Due data center sono certificati Tier IV dall’Uptime Institute. In questa visione, la fiducia (“trust”) tra provider e cliente si fonda su prestazioni, resilienza, sicurezza e compliance solide, per consentire alle imprese di concentrarsi su sviluppo e crescita mentre la piattaforma presidia i requisiti abilitanti.

Infrastrutture per l’intelligenza artificiale e workload critici: GPU, scalabilità e scelte operative

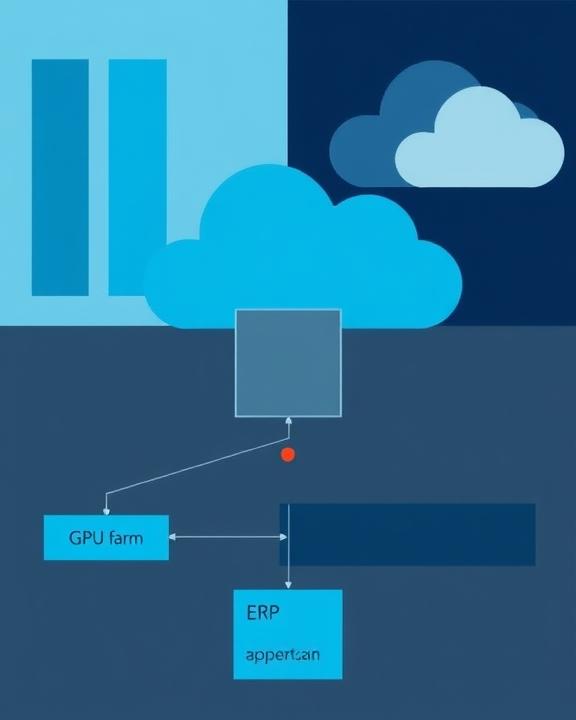

Le applicazioni di intelligenza artificiale richiedono un’infrastruttura adeguata, con un ruolo centrale delle GPU (Graphics Processing Units), progettate per compiti altamente paralleli e intensivi, come l’addestramento di modelli di machine learning. Queste farms si discostano dalle tradizionali server farm CPU‑centriche in termini di dimensionamento, raffreddamento, potenza e toolchain software; una progettazione imprecisa può ridurre drasticamente l’efficienza e la capacità d’erogazione del servizio. Le fonti sottolineano due percorsi di scelta: on‑premises o cloud.

La soluzione on‑premises conferisce controllo totale ma comporta alti investimenti iniziali, adeguamento di impianti (energia e cooling) e una gestione continua complessa. I cloud provider offrono invece GPU-as-a-Service con aggiornamenti infrastrutturali regolari, flessibilità e scalabilità elastica. In un contesto di domanda elevata – che può tradursi in lead time più lunghi e costi crescenti per l’acquisto diretto di GPU – le fonti citano l’accesso a risorse GPU su servizi come Azure, AWS e Google come opzione per accelerare lo start‑up dei progetti e il time-to-market. La componente umana rimane decisiva: servono competenze specifiche sugli algoritmi, l’orchestrazione GPU e l’ottimizzazione delle pipeline; in alternativa, si ricorre a esperti esterni per colmare rapidamente i gap e mantenere il passo con l’innovazione.

In scenari multicloud e ibridi, le tecnologie container, microservizi e Kubernetes supportano portabilità e gestione coerente. Combinare Public Cloud per burst di calcolo con ambienti privati per dati sensibili è prassi consigliata dalle fonti per equilibrare data sovereignty e time‑to‑compute. Qui si innestano i servizi gestiti: WIIT evidenzia che la propria piattaforma Secure Cloud, distribuita su 7 Region e con Zone modulabili (Standard, Premium, DR), è progettata per ospitare anche processi innovativi – tra cui quelli di AI – garantendo security by design, alta disponibilità e aderenza normativa come requisiti abilitanti, non come opzioni aggiuntive.

Dal punto di vista operativo, tre elementi risultano cruciali:

- Integrazione dati. La qualità dei dataset e il loro posizionamento fisico incidono su tempi, costi e risultati. In ambiente multicloud, spostamenti massivi tra provider possono generare oneri e latenza; la scelta della region e dell’architettura dati va compiuta tenendo conto di residenza, compliance e performance.

- Osservabilità end‑to‑end. Metriche, log e tracing centralizzati supportano il troubleshooting e l’ottimizzazione; AIOps consente individuazione proattiva di anomalie e automazione delle risposte, riducendo il mean time to resolution.

- Security e accessi. La federazione delle identità e la gestione centralizzata delle chiavi crittografiche sono requisiti essenziali per proteggere dati e modelli in esecuzione su domini diversi, garantendo least privilege e tracciabilità.

Queste indicazioni non esauriscono la complessità progettuale, ma delineano un perimetro pratico: dimensionare in funzione del valore di business, scegliere il mix infrastrutturale adeguato (con modelli as‑a‑service ove opportuno), e appoggiarsi a partner con data center ad altissima resilienza, SOC 24/7 e SLA coerenti con la criticità dei processi.

ERP e filiera nel pharma: indicazioni dal caso SAP S/4 Hana

Il settore pharma esemplifica bene la convergenza tra governance dei dati, compliance e innovazione. Le fonti riportano che SAP S/4 Hana – oltre ad abilitare la data‑driven company – facilita la gestione integrata dei processi core: dalla R&D alla produzione, dalla qualità fino alla logistica e alla distribuzione, con una visione end‑to‑end in cui Business Intelligence e ERP coesistono. In ricerca e sviluppo, la piattaforma aggrega dati provenienti da framework internazionali e li connette con asset interni e struttura organizzativa per pianificare flussi di lavoro coerenti con obiettivi di rilascio, sicurezza del prodotto e capacità produttiva effettiva. Nell’ambito qualità, la business intelligence supporta la conformità alle Current Good Manufacturing Practice (FDA) e lo sviluppo di KPI stringenti, ad esempio per i processi distributivi o per l’ottimizzazione proattiva delle scorte, un fattore decisivo per i produttori di medicinali.

La vocazione dell’ERP per procurement, ottimizzazione della supply chain e rafforzamento dei canali di distribuzione è amplificata dalla disponibilità di dati lungo l’intera filiera: previsioni di approvvigionamento e contrattualistica possono essere semplificate sfruttando sia informazioni di contesto aggiornate (prezzi delle materie prime, benchmark di mercato, variazioni socio‑economiche internazionali) sia insight in tempo reale estratti dai dati proprietari. Allo stesso modo, la capacità di monitorare performance di magazzino, stato dei servizi di trasporto e conservazione specifici per il farmaceutico, e andamento dei canali di vendita, consente interventi tempestivi su colli di bottiglia e livelli di servizio.

L’intersezione con il cloud è duplice. Da un lato, scalabilità e automazione della componente applicativa – specie in scenari multicloud – aiutano a gestire picchi di domanda analitica e processi di integrazione dati. Dall’altro, i requisiti di sicurezza, residenza e auditabilità restano stringenti, con preferenza per ambienti single‑tenant gestiti con SLA chiari e funzioni di security-by-design. Qui si inserisce la proposta di WIIT: il Secure Cloud – distribuito in 7 Region con Zone attivabili – è dimensionato per ospitare workload critici (ERP compresi) preservando alta disponibilità, compliance e security in continuità, e si integra con servizi di Business Continuity e cybersicurezza in ambito sanitario già citati nelle fonti WIIT.

Infine, le imprese del comparto stanno vivendo l’integrazione del core pharma con mondo digitale, IoT per terapie e‑health e medicina personalizzata. In questo scenario, lo strumento gestionale deve consentire la tracciabilità di materiali e lotti, il governo dei processi di procurement, produzione, scorte e logistica, con metriche economiche e di efficienza integrate. L’obiettivo è coniugare norme e agilità tipiche di un settore dinamico e competitivo. Una piattaforma ERP‑centrica, ospitata su infrastrutture robuste e governata in architetture multicloud/ibride con policy coerenti, costituisce – secondo le fonti – un fattore abilitante per la qualità operativa e la compliance in contesti transnazionali.

Strategie operative e modelli architetturali: interoperabilità, latenza e gestione dei dati

Costruire un’architettura multicloud impone scelte consapevoli su spostamento dei dati, latenza, interoperabilità, orchestrazione e sicurezza. Le fonti suggeriscono best practice incrementali:

Pianificare migrazione e integrazione

Selezionare piattaforme che supportino integrazione nativa e interconnessioni dedicate tra cloud riduce la complessità: i fornitori stanno sviluppando partnership che migliorano latenza e diminuiscono i costi di uscita dati, semplificando i flussi applicativi ibridi. La standardizzazione su container, microservizi e Kubernetes fornisce una base comune per la portabilità, mentre service mesh e strumenti di configuration/policy management abilitano controlli coerenti a cavallo dei domini.

Best Practice per la Sicurezza di Kubernetes in Ambienti Complessi

Poiché Kubernetes è diventato un componente fondamentale delle architetture multicloud, la sua messa in sicurezza è una priorità assoluta. Esperti di settore raccomandano un approccio a più livelli per proteggere i cluster.[Check Point]

- Image Assurance: Analizzare le immagini dei container prima e durante l’esecuzione per rilevare vulnerabilità, malware o configurazioni non sicure. Impedire il deployment di immagini non conformi alle policy.

- Gestione della Postura e Visibilità: Configurare i cluster secondo standard di settore (es. CIS Benchmarks) e ottenere visibilità continua su tutti i carichi di lavoro. Automatizzare (“shift left”) la sicurezza integrandola nelle pipeline CI/CD.

- Policy Enforcement con Admission Controller: Utilizzare i controller di ammissione per intercettare e validare le richieste API al cluster, bloccando configurazioni non sicure prima che vengano applicate.

- Protezione Runtime Intelligente: Impiegare soluzioni che profilano il comportamento normale dei carichi di lavoro (processi, attività di rete) per rilevare anomalie e minacce in tempo reale, combinando analisi comportamentale e database di firme malevole.

- Micro-segmentazione: Implementare policy di rete granulari per limitare la comunicazione tra pod e servizi solo a quanto strettamente necessario, riducendo la superficie d’attacco e il movimento laterale in caso di breccia.

Definire una strategia dati coerente

Il dato è il primo vincolo architetturale. Le fonti raccomandano di limitare lo spostamento trans-cloud, che aumenta costi e complessità di sicurezza, privilegiando – quando possibile – l’utilizzo di lo stesso motore di database nei diversi cloud già in uso e mantenendo governance e safety nei sistemi strategici. La localizzazione dei dataset deve riflettere requisiti di residenza e privacy, oltre che vincoli di latenza applicativa. In più, i servizi di integrazione ed automazione dei provider possono agevolare staging e sincronizzazioni, ad esempio per scopi analitici.

Minimizzare la latenza e stabilire procedure standard

La latenza di rete influenza direttamente l’esperienza utente e l’efficienza. È opportuno contenere l’utilizzo dei dati di ciascuna applicazione nel singolo cloud, ricorrendo a interconnessioni per i punti realmente necessari. Sul piano operativo, ogni provider ha API, strumenti di automazione e dashboard diversi: procedure standard di gestione e strumenti di orchestrazione trasversali aiutano a ridurre l’onere cognitivo e i rischi di configurazione incoerente.

Gestione delle API e sicurezza degli endpoint

L’interconnettività tra servizi espone nuove superfici d’attacco. È quindi essenziale consolidare endpoint API, unificare gestione identità e accessi, definire permessi minimi e mantenere osservabilità centralizzata degli scambi. Le fonti raccomandano un approccio multilivello, che impieghi servizi di sicurezza integrati di ciascun cloud in combinazione con partnership e controlli sovra-ordinati di governance.

Questo impianto tecnico non prescinde dal fattore umano: la gestione di piattaforme eterogenee crea fabbisogni di competenze trasversali (non solo specialistiche per singolo cloud) e capacità di interpretare compliance e risk management in ottica multi‑dominio. È su questo terreno che un operatore come WIIT, con data center proprietari, Premium Zone e SOC 24/7, abbina la componente infrastrutturale a un approccio consulenziale – espressamente suggerito nelle fonti – per disegnare, implementare e gestire soluzioni “su misura” del business, della normativa e degli obiettivi del cliente.

Indicatori, SLA e scelta del provider: criteri pratici e impatti sul business

La selezione del provider in ambito Private/Hybrid Cloud – e più in generale nel multicloud – ha impatti diretti su business continuity e prestazioni. Le fonti sottolineano quattro criteri: esperienza e competenze comprovate; ampiezza dell’offerta (capacità di coprire l’intero spettro, dal managed hosting fino alla sicurezza gestita e al disaster recovery); infrastruttura proprietaria con sedi e certificazioni adeguate alle esigenze di compliance; e SLA formalizzati e misurabili. A questi si aggiunge il approccio consulenziale necessario per governare la complessità e personalizzare i controlli nel tempo.

Sul versante economico, il confronto TCO tra pubblico e privato non ha una risposta univoca: molto dipende dall’orizzonte temporale, dalla scala, dalla criticità e dal mix di funzionalità richieste. Le fonti riportano che, sotto determinate condizioni e con una gestione efficiente, mantenere una Private Cloud per più anni può risultare più conveniente del pubblico, in virtù di costi trasparenti e prevedibili. Si tratta di valutazioni che beneficiano di metriche di utilizzo e di prestazione precise, e di una mappa degli obiettivi di business per ogni workload.

Al contempo, la realtà delle migrazioni “di ritorno” – 48% dei CIO secondo il sondaggio 451 Research citato – testimonia che la portabilità e il mantenimento di standard di interoperabilità non sono aspetti teorici: disporre di exit strategy e piani di re‑hosting riduce il rischio di lock‑in e consente di riallineare il portafoglio in funzione di performance e costi reali. In questa logica, il modello Hosted/Virtual Private Cloud e le architetture ibride consentono di sfruttare i benefici del cloud senza rinunciare al controllo e alla prossimità dell’infrastruttura per i processi più sensibili.

Infine, l’adeguamento normativo – NIS2 in primis – introduce ulteriori parametri: registrazioni periodiche presso piattaforme istituzionali (a partire dal 1° dicembre di ogni anno), processi di notifica e misure tecniche/organizzative richieste dal legislatore a partire dal 2026, oltre a politiche di formazione, business continuity e crittografia. Le stime di costo (280.000 euro medi per adeguamento; 4,71 milioni di euro il costo medio di un data breach nel 2024) completano il quadro, suggerendo che investimenti in security embedded e governance coesa siano non solo essenziali per la continuità, ma economicamente razionali. In questo ambito, soluzioni come il Secure Cloud di WIIT, con Premium Zone e Tier IV dove necessario, e servizi di Business Continuity, si propongono come piattaforme concrete per trasformare requisiti in valore, in contesti anche fortemente regolamentati.

Prospettive per i prossimi 12–24 mesi: multicloud responsabile e centralità della governance

Guardando alle traiettorie emerse nelle fonti, l’attenzione converge su alcuni snodi decisivi. Primo, la gestione unificata di ambienti multicloud e ibridi si afferma come prerequisito per scalare in sicurezza: policy as code, observability end‑to‑end e AIOps sono gli strumenti che trasformano la complessità in repeatability, riducendo errori e tempi di intervento. Secondo, la sicurezza deve essere intrinseca all’architettura: le statistiche citate su CISO, OT e costi dei breach suggeriscono che i piani di difesa reattivi non bastano; servono modelli proattivi con monitoraggio continuo (SOC 24/7), controllo identità, gestione chiavi e filiere fornitore sicure. Terzo, i requisiti normativi – con NIS2 già calendarizzata – impongono processi documentati e tecnologie abilitanti; non solo per evitare sanzioni, ma per sostenere la resilienza operativa e la fiducia degli stakeholder.

Proiezioni di mercato e visione a lungo termine

Le previsioni per il mercato cloud italiano indicano una crescita robusta e sostenuta, proiettando il suo valore a 31,75 miliardi di dollari entro il 2030.[Mordor Intelligence] Questa crescita non sarà guidata solo dall’espansione dei volumi, ma da una sempre maggiore maturità nell’adozione. Le aziende si muoveranno verso un “multicloud responsabile”, dove la scelta dei provider non sarà più tattica ma strategica, basata su un equilibrio ponderato tra innovazione tecnologica (es. servizi AI), ottimizzazione dei costi (TCO), sovranità del dato e garanzie di conformità normativa. La governance centralizzata e la sicurezza proattiva diventeranno i fattori determinanti per trasformare l’investimento in cloud da un centro di costo a un reale vantaggio competitivo.

In questo scenario, la proposta infrastrutturale e di servizio WIIT – Secure Cloud, 7 Region europee, Premium Zone con Tier IV e SOC 24/7, più servizi gestiti di Business Continuity e cybersecurity – si allinea ai punti cardinali emersi dalle fonti: performance prevedibili, resilienza architetturale, security-by-design e compliance integrata. La maturità nel trattare workload critici (ERP, supply chain, dati clinici, processi finanziari) e nel supportare iniziative AI‑enabled rende possibile adottare il multicloud in modo responsabile, trasformandolo da progetto IT a vantaggio competitivo misurabile. Per le organizzazioni che intendono consolidare questa traiettoria, il passo successivo è istituzionalizzare processi, metriche e ruoli coerenti con gli obiettivi di business, sfruttando partner capaci di integrare infrastruttura, servizi gestiti e consulenza in un’unica piattaforma.

Lascia un commento